С AI в тестировании сейчас происходит странная вещь. Кто-то пытается использовать его везде, а кто-то опасливо поглядывает, предпочитая не подпускать к процессам вообще. И то и другое, конечно, ненужные крайности. Можно найти уже сотни примеров проектов, где ИИ сокращал время релиза и делал работу QA спокойнее, предотвращая нервный тик от тысячного повтора рутинной операции. И тем не менее, если начнем искать, то увидим и достаточно случаев, где ИИ ускорял выпуск… багов в прод.

Но проблема не в технологии как таковой, а в ожиданиях. Многим, кто начинает пользоваться ИИ и восхищается результатами, сложно понять, что он не думает за тестировщика, какой бы супер-промт вы ни написали, и не понимает продукт так, как человек, как бы вы ему этот продукт ни скармливали в описании/изображении/схеме. Зато AI отлично забирает на себя механическую работу и помогает увидеть то, что нам сложно удержать в голове. Так что если в 2026 году вы всё ещё продаете (или покупаете) чисто ручное тестирование «по старинке», у меня для вас плохие новости. Вы либо неоправданно богаты, либо сознательно тормозите свой Time-to-Market (TTM). Там, где циклы разработки сократились до часов, классический подход к качеству стал бутылочным горлышком.

Если трезво смотреть на вещи, то сделать красиво моментально ИИ не поможет. Если не разобраться в сути, то можно нагенерировать столько высокотехнологичного мусора, что полгода разгребать придется. Но в руках зрелой команды это просто клад, инженерный экзоскелет, который позволяет не раздувать штат QA, сохраняя при этом хорошую скорость релизов.

Мы уже писали о том, как на практике наши специалисты применяют ChatGPT в тестировании и как правильно писать промты для решения задач QA. Сегодня я хочу напомнить о главное и показать, в каких 5 зонах можно заставить нейронки окупаться, а также «красные флаги», которые должен видеть каждый CTO.

Тренды и фишки из мира IT,

экспертные статьи и всё о тестировании.

Тест-дизайн и «Шредер» для рутины

Написание тест-кейсов по API-спекам или User Stories вполне механическая работа, которая исторически убила мотивацию не одного QA, к сожалению. Джуны сходят с ума сначала от радости, что им доверили большой объем, потом от усталости, потому что этот объем никак не заканчивается. А ведь можно перевести эту задачу на уровень AI-First QA.

Скармливаете модели требования, а на выходе получаете структурированный драфт: Happy Path, граничные значения и каверзные негативные сценарии.

На уровне 2026 года ИИ умеет генерировать готовые Gherkin-сценарии или Playwright/Cypress шаблоны. ИИ помогает набросать структуру, но за архитектуру тестов по-прежнему отвечает человек. На старте проекта это экономит до 60% времени. Иногда все же проверка того, что нагенерировал ИИ занимает тоже немало времени.

Стоит помнить, однако, что ИИ неплохо «галлюцинирует» с уверенностью эксперта. Если в документации дыра, нейронка не задаст вопрос, а выдумает логику и допишет сценарий сама. Поэтому грамотно делегировать ИИ объем, а человеку оставлять работу с контекстом и финальный аппрув.

Self-Healing – конец эры «упавших» локаторов

Еще несколько лет назад изменение ID кнопки на фронтенде означало смерть половины автотестов и работу в форс-мажоре для команды. Теперь профи это считают моветоном.

На деле вы внедряете Self-healing механизмы (самовосстанавливающиеся системы) и если тест не находит элемент по старому селектору, то ИИ-агент анализирует DOM-дерево в момент падения теста. Он понимает: «Окей, ID изменился, но эта кнопка всё еще находится в блоке оплаты и имеет текст «Купить»». В результате тест не падает, а тестировщик с утра получает отчет о том, что агент подправил локатор, нужна проверка и мердж. В этом случае расходы на поддержку (Maintenance) тестов снижаются на 40%.

Smart Regression – игра в рулетку уже не в моде

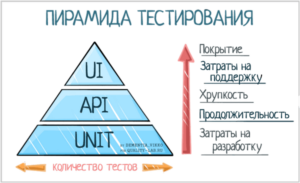

С мелкими проектами проще работать, но когда у вас в бэклоге тысячи тестов, а релиз был назначен на «вчера», полная регрессия становится, мягко говоря, в тягость. Классическая приоритизация «на глаз» с большой вероятностью приведет к инциденту на проде.

Подключайте предиктивную аналитику, это и есть экспертный подход. Искусственный интеллект анализирует историю падений, свежие коммиты в Git и данные мониторинга из Grafana. Система сама собирает Risk-based пакет. И пока конкуренты гоняют полные тесты по несколько часов, вы проверяете только то, что реально могло сломаться, и даете аппрув за 40 минут. И это прямая экономия на CI/CD пайплайнах.

Генерация синтетических данных (TDM)

В 2026 году требования к безопасности (GDPR, 152-ФЗ) стали драконовскими. Использовать реальные данные клиентов для тестов – подсудное дело. Есть хорошее решение – обучить локальные модели на структуре БД проекта. ИИ генерирует синтетические датасеты: миллионы транзакций, профилей и заказов, которые выглядят как реальные, но не содержат персональных данных. Это дает вам тестирование на «живых» объемах данных без единого риска утечки.

RCA и анализ багов – паттерны против хаоса

Когда в Jira падает гора тикетов, человек видит симптомы. ИИ помогает коррелировать логи с шагами воспроизведения – отлично делает Clustering (группировку похожих багов) и действует в RCA, Root Cause Analysis (анализ корневых причин, структурированный метод поиска истинного источника проблемы). С этим анализом нейронка выявляет хрупкие модули и сопоставляет логи сервера с описанием бага. Для PM ценность такого подхода неоценима, потому что вместо отчета вроде «у нас 50 багов», вы получаете полный расклад типа: «Система деградирует в модуле оплаты из-за конфликта типов в API. Вот 5 связанных кейсов». Время на локализацию ошибки (MTTR) в этом случае сокращается в 3 раза.

Где ИИ – прямая угроза

Опытные команды принципиально не доверяют ИИ в трех случаях.

Security & Data Privacy.

Скармливать закрытую архитектуру в публичный ChatGPT равносильно, что купить билет в один конец до штрафов и репутационного краха. Важно работать через Enterprise-API с гарантией безопасности данных или можно развернуть локальные современные open-source модели (семейства Llama, Mistral и др.) внутри защищенного контура компании.

Сложные бизнес-домены

В финтехе, медтехе или софте для промышленности цена глюка ИИ слишком высока – реальные деньги или человеческие жизни. Здесь нейронка может быть только ассистентом, последнее слово всегда за экспертом.

UX и человечность

Нейронка никогда не скажет вам, что у вашей разработки отстойный интерфейс и что ее раздражает кривой путь к корзине или оплате. Такую штуку, как продуктовое чутье автоматизировать пока не удалось.

Эффективность в цифрах (ROI для бизнеса)

| Процесс | Роль ИИ в работе команды | Итог для клиента |

| Test Design | Генерация сценариев и Gherkin как черновика | Сокращение фазы подготовки тестов примерно на 50% |

| Regression | Risk-based фильтрация регресса | Ускорение цикла тестирования (Testing Cycle Time) |

| Maintenance | Self-healing локаторов автотестов | Снижение затрат на поддержку тестов до 40% |

| Bug Analysis | RCA-ассистент для анализа дефектов | Локализация причин багов до 70% быстрее |

Резюме

ИИ в тестировании не заменяет специалиста, а усиливает его, становясь тем самым экзоскелетом. Не нужно бездумно сокращать QA-отделы в надежде на машины, но и отказываться растить AI-augmented инженеров не стоит. Они могут работать в 10 раз быстрее и точнее классического ручного тестирования и быть главным конкурентным преимуществом. Конечно, при условии, что ИИ под контролем эксперта. И таких экспертов можно найти в ЛК.