Если работать в сфере тестирования достаточно долго, начинаешь замечать забавную закономерность. Чем сильнее техлид, тем тише появляются баги. Они как будто выжидают момент, и предательски вылезают там, где процесс увело в сторону, а вовсе не там, где что-то написано плохо. Вроде бы все всё делали правильно, UI зелёный, пайплайн прошёл, зарелизились и…упс, на проде что-то легло.

Очень часто, когда команда начинает разбираться, оказывается, что причина не в чьём-то «косяке» (хотя и такое бывает, никто не застрахован). Но чаще всё-таки она в слепой зоне, которую никто не увидел, потому что все посовещались и решили, что «вот здесь мы точно всё закрыли».

Слепые зоны растут не из ошибок. Они растут из спокойной уверенности, что архитектура уже выдержала, например, два больших релиза, поэтому выдержит и третий. Растут из решений, которые когда-то казались удобными. Такие штуки редко видно изнутри разработки. Когда у техлида в голове архитектура, найм, сроки и прод, то тестирование кажется понятным процессом: прогоняем сценарии, автоматизируем, меряем покрытие. На деле оно живёт чуток по другим законам.

Тестирование показывает, где в логике продукта возникает неопределённость, куда стекаются побочные эффекты и что ломается, когда система ведёт себя иначе, чем ожидалось.

Нам всем стоит принять тот факт, что мы стоим на пороге 2026 года – эры AI-кода, динамических интерфейсов и мгновенной смены контрактов. В этих условиях старые стратегии контроля качества в частном случае дадут кратковременный сбой, а глобально просто начнут тормозить саму разработку.

В статье обсудим пять зон, которые техлиду стоит пересмотреть уже сейчас.

Переоценка UI как «источника истины»

Есть команды, где тестирование на 90% состоит из UI-тестов. Логика простая: «пользователь работает через интерфейс, значит, там и проверяем». Пока проект небольшой моноліт на 5 форм, это даже работает. Но как только система обрастает сервисами и API, UI превращается в тонкий слой грима, который показывает картинку, но скрывает реальное состояние.

Проблема не только в хрупкости UI-тестов. Главная беда в том, что UI не показывает связность. Если тест упал, вы не знаете, что именно треснуло: кнопка переехала, API вернул 409 Conflict из-за гонки данных или сервис завис на ретраях.

Я работала на проекте, где UI-тесты неделями были зелёными, а в проде раз в час «залипала» корзина, потому что фронт подтягивал старый контракт. Никакой E2E этого не ловил.

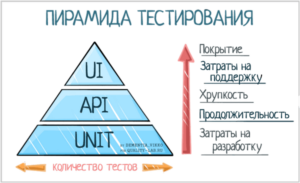

Здесь почти всегда всплывает перевёрнутая пирамида тестирования. Все её знают, все признают, но всё равно пишут сотни UI-тестов вместо нормального API- и контрактного покрытия. UI-тесты проще показать менеджменту, проще объяснить, проще «продать». Пока они не начинают падать из-за анимации или переехавшей кнопки, а реальный дефект живёт глубоко в сервисе.

В 2026 году UI-first стратегия станет прямым ограничением. Server-Driven UI, персонализация, динамические конфигурации сделают поддержку большого UI-пакета почти невозможной.

Что делать? Смещать фокус вниз по пирамиде тестирования. Контрактные тесты, API-покрытие, наблюдаемость. Всё, что ниже UI, должно проверяться раньше и жёстче.

Тренды и фишки из мира IT,

экспертные статьи и всё о тестировании.

Недооценка тестового анализа и Shift-Left

Тест-анализ – самая невидимая часть работы QA, которую считают как будто чем-то само собой разумеющимся. Со стороны кажется, что есть требования, задачи и фичи, а мы, то есть тестировщики, и так разберемся. Но без анализа тестирование почти всегда превращается в проверку HappyPath.

Типичная ситуация для многих, к сожалению, когда команда реализует ретраи (повторные запросы) для внешнего сервиса, но никто не обсуждает, какие ответы считаются фатальными. Система живёт в режиме «вроде работает», пока под нагрузкой не начинается рост запросов в геометрической прогрессии. Под нагрузкой это приводит к DDoS-атаке на самих себя.

С приходом AI-генерации кода Time-to-Code ускорится в разы. Бэклог будет закрываться быстрее. Если нет фильтра на уровне тест-анализа, в прод будет улетать логика, которую никто толком не собирал как систему.

Shift-Left нам нужен не из-за модного веяния. Это реально единственный способ поймать архитектурные риски до того, как тот же Copilot напишет идеальный, но концептуально неверный кусок кода.

Какой выход? Пользоваться по максимуму тест-анализом и методом раннего тестирования, тестировщик должен валидировать архитектуру до написания кода. Очевидно же.

Автоматизация ради галочки

Автоматизация без архитектуры – абсолютный карго-культ. Тесты вроде есть, но запускать их страшно. Самый частый паттерн, когда тесты гоняются последовательно, данные живут в одной базе, а один нестабильный сценарий красит весь пайплайн. В какой-то момент команда начинает временно отключать проверки, и CI превращается в декорацию.

Мой коллега совсем недавно поделился примером: деплой фичи зависел от случайного UI-теста оплаты, который ходил в stage за реальными данными. Один сбой в банке – и релиз встал. Через месяц такую автоматизацию отключили.Игнорирование пирамиды тестирования здесь становится архитектурным анти-паттерном. Если 80–90% покрытия приходится на UI, это не контроль качества, а дымовая завеса, Потёмкинская деревня…называйте, как нравится, только не делайте так 🙂

Как исправить? Относиться к автотестам как к продакшн-коду. Атомарность, изоляция данных, моки внешних зависимостей, параллельный запуск. Автоматизация должна ускорять CI/CD, а не быть причиной его красного цвета.

Ожидание, что QA «сам увидит риски»

Это одна из самых человечных и самых дорогих ошибок. Техлиды часто думают, что опытный QA интуитивно догадается, где риски. Но риски видит тот, кто знает путь данных.

Если команда внедряет кэширование или шардирование баз данных, но не доносит это до отдела тестирования, значит, QA работают вслепую. У нас как-то был баг с кэшем, который воспроизводился раз в сутки при ротации ключей. При этом тесты были зелёные. Отдел просто не знал, что ключи ротируются.

Вот вам мини-диалог, который встречается чаще, чем кажется:

– Мы же это обсуждали на архитектурной встрече!

– А нас (тестеров) там не было…

Что делать? ADR, которые фиксируют ключевые архитектурные решения, и участие QA в Design Review решают эту проблему лучше любых митингов. Тестирование перестаёт быть угадайкой и начинает бить точно в узкие места.

Игнорирование «радиуса поражения»

Это эффект бабочки, вы же понимаете… В распределённых системах «маленького изменения» не существует. Даже обновление библиотеки сериализации может поломать отчёты, которые собираются раз в месяц.

Один клиент «подарил» нам классический пример того, как, казалось бы, незначительное изменение в upstream-сервисе (отправителе данных) приводит к катастрофическому и тихому сбою в downstream-сервисе (получателе данных). Изменение одного поля в контракте (с int на float) без предупреждения убило ночной процессинг транзакций. Он завершился без критических ошибок, но ВСЕ транзакции, отправленные после изменения контракта, молчаливо «потеряны» (dropped) и не попадают в БД. Обнаружилось это только через несколько дней, когда бизнес-отчеты показывают расхождение в данных.

Как быть? Контроль качества должен сдвигаться не только влево, но и вправо (Testing in Production).Feature Flags, канареечные релизы, мониторинг логов нужны не для поиска багов на проде, а чтобы минимизировать ущерб, когда (а не если) что-то пойдет не так.

В итоге

Большинство слепых зон возникают не из-за людей и не из-за инструментов. Они появляются, когда архитектура развивается быстрее, чем стратегия её проверки.

Как QA, я могу сказать простую вещь. Когда техлид вовлекается в обсуждение рисков, уровней тестирования и архитектуры автотестов, слепые зоны исчезают почти полностью. Здесь не пахнет процессом ради процесса. Все четко только для экономии времени, сил и нервов всей команды.

Мы перед началом 2026 года уже совсем близки к тому, что тестирование перестанет быть фазой и станет свойством архитектуры.

Почему в 2026 это станет критично?

- AI и ML перестанут быть фичами и превратятся в ядро продукта. Проверять такие системы только через UI всё равно что проверять двигатель самолёта, водя рукой по обшивке. Здесь нужны тесты данных, мониторинг дрейфа и контроль выводов модели. Если техлид не думает о тестировании данных, то модель станет источником рисков.

- API-first и микросервисность станут дефолтом. Без контрактного тестирования интеграционные сбои будут постоянными, мелкие изменения будут ронять цепочки сервисов с той же регулярностью, с какой сейчас ломается UI. Локализовать их на 100% не получится.

- Full-Stack QA больше не доп.функция и не «продвинутые знания». Это станет, если еще не стало, базовым уровнем. Об этом сейчас очень много споров на разных площадках среди тестировщиков… Но, как ни крути, QA без навыков кода, пайплайнов и мониторинга будет просто не успевать за релизами.

Бонус: Метафора будущего (или при чем тут Леннон)

Сфера нашей работы, создание и тестирование ПО, меняется необратимо. Мы с ИИ теперь как Джон Леннон и Йоко Оно: неразлучный, радикальный и творческий союз, который разрушает старые традиции. Наша связь скандальна для консерваторов, но жизненно необходима для прорыва.

ИИ – наша Йоко, новый, концептуальный элемент, который заставляет нас, Леннонов (тестировщиков, живых и с человеческой интуицией), выйти из зоны комфорта (представим, что мы все же туда когда-то зашли, да?).

ИИ приносит крутую автоматизацию и анализ Big Data. Мы обеспечиваем эмоциональный интеллект, эмпатия и финальное, осмысленное видение качества. Это не просто сотрудничество. Это, если хотите, творческий симбиоз. Вместе мы пишем новую главу, где качество окончательно перестает быть механической проверкой и становится настоящим искусством.

Тестовая стратегия + продолжение архитектуры. Если одно хромает, второе не спасёт. Когда техлид это видит, команда не спотыкается, движется быстрее и увереннее. Когда не видит, то… можете проверить – к концу 2026 слепые зоны вашего проекта перестанут быть тихими.

Что вы можете сделать прямо сейчас?

* звать QA на старт обсуждения фич;

* переводить автотесты с UI на API, где это рационально;

* навести порядок в окружениях;

* прокачать QA в логах, метриках, пайплайнах;

* перестать верить, что «UI найдёт всё».

Специалисты ЛК хорошо разбираются в своем деле. Если хотите посмотреть на свою тестовую стратегию свежим взглядом, мы можем помочь.